Weblog von Beat Döbeli Honegger

Dies ist der private Weblog von Beat Döbeli Honegger

Categories

- 78 Annoyance

- 121 Biblionetz

- 7 Bildschirme

- 9 Bildungspolitik

- 8 DPM

- 11 Digital Immigrants

- 3 Elektromobil

- 19 GMLS

- 64 Gadget

- 55 Geek

- 7 GeoLocation

- 14 HandheldInSchool

- 107 Informatik

- 26 Information-Architecture (IA)

- 11 Kid

- 79 Medienbericht

- 135 Medienbildung

- 7 Modelle

- 30 OLPC

- 49 PH Solothurn

- 35 PHSZ

- 4 RechtUndInformatik

- 155 Schul-ICT

- 20 Scratch

- 7 SecondLife

- 107 Software

- 52 Tablet-PC

- 144 Veranstaltung

- 15 Video

- 61 Visualisierung

- 124 Wiki

- 20 Wissenschaft

- 7 Zeitschrift c't

Archive

- 3Feb 2026

- 8Jan 2026

- 7Dec 2025

- 2Nov 2025

- 2Oct 2025

- 2Sep 2025

- 1Aug 2025

- 4Jul 2025

- 1Jun 2025

- 5May 2025

- 5Sep 2024

- 1Aug 2024

- 2Jul 2024

- 1Jan 2024

- 1Dec 2023

- 1Sep 2023

- 2Jul 2023

- 1Jun 2023

- 1Mar 2023

- 1Feb 2023

- 1Jan 2023

- 1Jul 2022

- 1Jan 2022

- 1Oct 2021

- 1Sep 2021

- 1Jun 2021

- 2Apr 2021

- 1Feb 2021

- 1Nov 2020

- 3Sep 2020

- 2Jun 2020

- 1May 2020

- 1Apr 2020

- 2Mar 2020

- 1Feb 2020

- 2Jan 2020

- 1Dec 2019

- 1Nov 2019

- 1Oct 2019

- 4Sep 2019

- 1Jul 2019

- 1Jun 2019

- 3Apr 2019

- 1Mar 2019

- 3Jan 2019

- 1Dec 2018

- 1Nov 2018

- 1Oct 2018

- 1Aug 2018

- 4Jun 2018

- 2Dec 2017

- 3Nov 2017

- 2Oct 2017

- 5Sep 2017

- 4Jul 2017

- 1Jun 2017

- 1Apr 2017

- 1Jan 2017

- 3Dec 2016

- 3Nov 2016

- 1Oct 2016

- 3Sep 2016

- 1Aug 2016

- 1Jun 2016

- 3May 2016

- 4Apr 2016

- 3Mar 2016

- 4Jan 2016

- 3Dec 2015

- 3Nov 2015

- 2Oct 2015

- 3Sep 2015

- 4Aug 2015

- 3Jul 2015

- 5Jun 2015

- 8May 2015

- 5Apr 2015

- 6Mar 2015

- 5Feb 2015

- 6Jan 2015

- 6Dec 2014

- 10Nov 2014

- 5Oct 2014

- 9Sep 2014

- 3Aug 2014

- 3Jul 2014

- 6Jun 2014

- 4May 2014

- 8Apr 2014

- 6Mar 2014

- 5Feb 2014

- 4Jan 2014

- 6Dec 2013

- 7Nov 2013

- 15Oct 2013

- 4Sep 2013

- 8Aug 2013

- 7Jul 2013

- 13Jun 2013

- 5May 2013

- 5Apr 2013

- 8Mar 2013

- 4Feb 2013

- 10Jan 2013

- 9Dec 2012

- 7Nov 2012

- 10Oct 2012

- 7Sep 2012

- 8Aug 2012

- 7Jul 2012

- 4Jun 2012

- 3May 2012

- 9Apr 2012

- 9Mar 2012

- 1Feb 2012

- 6Jan 2012

- 9Dec 2011

- 3Nov 2011

- 10Oct 2011

- 13Sep 2011

- 4Aug 2011

- 8Jul 2011

- 7Jun 2011

- 8May 2011

- 7Apr 2011

- 4Mar 2011

- 3Feb 2011

- 7Jan 2011

- 7Dec 2010

- 10Nov 2010

- 11Oct 2010

- 9Sep 2010

- 6Aug 2010

- 6Jul 2010

- 2Jun 2010

- 6May 2010

- 8Apr 2010

- 7Mar 2010

- 8Feb 2010

- 10Jan 2010

- 6Dec 2009

- 11Nov 2009

- 8Oct 2009

- 14Sep 2009

- 7Aug 2009

- 11Jul 2009

- 5Jun 2009

- 14May 2009

- 21Apr 2009

- 14Mar 2009

- 20Feb 2009

- 14Jan 2009

- 9Dec 2008

- 14Nov 2008

- 9Oct 2008

- 11Sep 2008

- 15Aug 2008

- 9Jul 2008

- 8Jun 2008

- 14May 2008

- 15Apr 2008

- 14Mar 2008

- 19Feb 2008

- 18Jan 2008

- 17Dec 2007

- 16Nov 2007

- 25Oct 2007

- 10Sep 2007

- 27Aug 2007

- 16Jul 2007

- 27Jun 2007

- 31May 2007

- 28Apr 2007

- 12Mar 2007

- 34Feb 2007

- 31Jan 2007

- 29Dec 2006

- 33Nov 2006

- 20Oct 2006

- 35Sep 2006

- 42Aug 2006

- 35Jul 2006

- 31Jun 2006

- 29May 2006

- 23Apr 2006

- 20Mar 2006

- 23Feb 2006

- 43Jan 2006

- 26Dec 2005

- 31Nov 2005

- 31Oct 2005

- 14Sep 2005

- 31Aug 2005

- 24Jul 2005

- 1Jul 2004

You are here: Weblog von Beat Döbeli Honegger

Claude beim Arbeiten zusehen

Wozu agentische Systeme so fähig sind

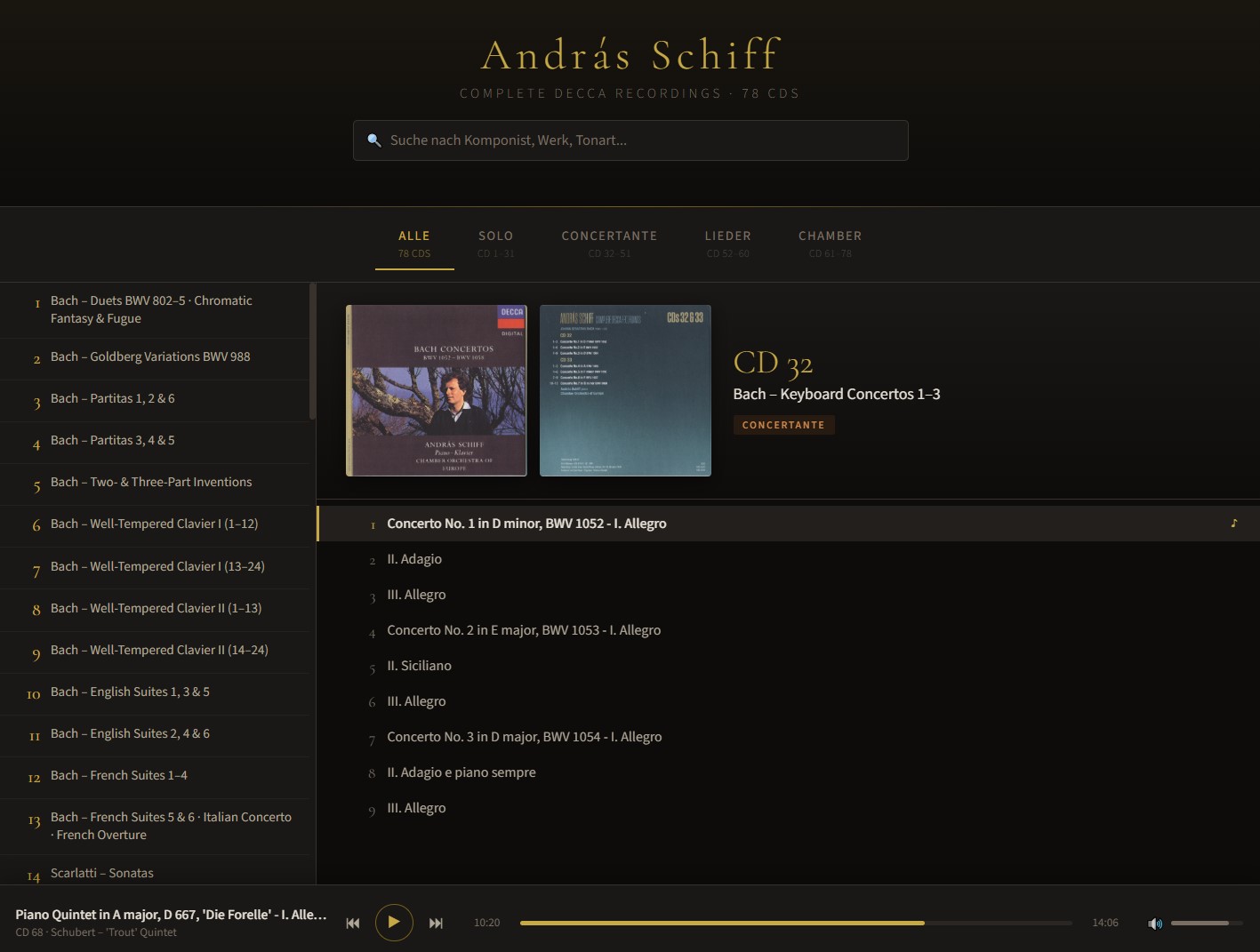

Im Folgenden beschreibe ich, was Claude Opus 4.6 im Februar 2026 aufgrund eines einzigen Prompts auf meinem Computer erstellen konnte. Natürlich wusste ich theoretisch, dass so etwas geht. Sieht man dann dem generativen Machine-Learning-System während 20 Minuten zu, wie es die Aufgabe löst, ist es nochmals was anderes.

Claude hat mir aufgrund eines einzigen Prompts aus einer riesigen MP3-Sammlung im Umfang von 78 CDs, Coverbildern und einem Booklet als PDF eine strukturierte HTML-Oberfläche für den Browser mit Volltextsuche und integriertem Player gebaut:

Den Raspberry Pi ins böse Internet hängen

Praktische Sicherheitsüberlegungen auf dem Weg zur eigenen digitalen Souveränität

19 February 2026

| Beat Döblei Honegger

Auch wenn es verlockend bequem ist, möchte ich nicht mehr alle meine Daten auf fremden Wolken lagern. Als Schritt zur persönlichen digitalen Souveränität habe ich deshalb angefangen, gewisse Dienste selbst zu hosten. Dafür könnte ich entweder einen virtuellen Server bei einem Provider mieten oder aber mir selbst einen kleinen Server in die Wohnung stellen und selektiv den Zugriff aus dem Internet auf diesen Server erlauben.

Ich habe mich für den eigenen Server im Bücherregal in Form eines Raspberry Pi 5 entschieden. Einerseits, weil dieser Server auch die Haussteuerung übernimmt, andererseits weil es darauf auch Daten hat, welche die Wohnung eigentlich nicht verlassen sollten. Ist es da nicht gefährlich, Löcher in die Firewall meines Internet-Routers zu bohren?

Es gibt folgende Möglichkeiten:

Es gibt folgende Möglichkeiten:

Es gibt folgende Möglichkeiten:

Es gibt folgende Möglichkeiten:

Warum ich Tofu bei der Arbeit nicht mag

Wenn unterschiedliche digitale Arbeitsweisen aufeinandertreffen

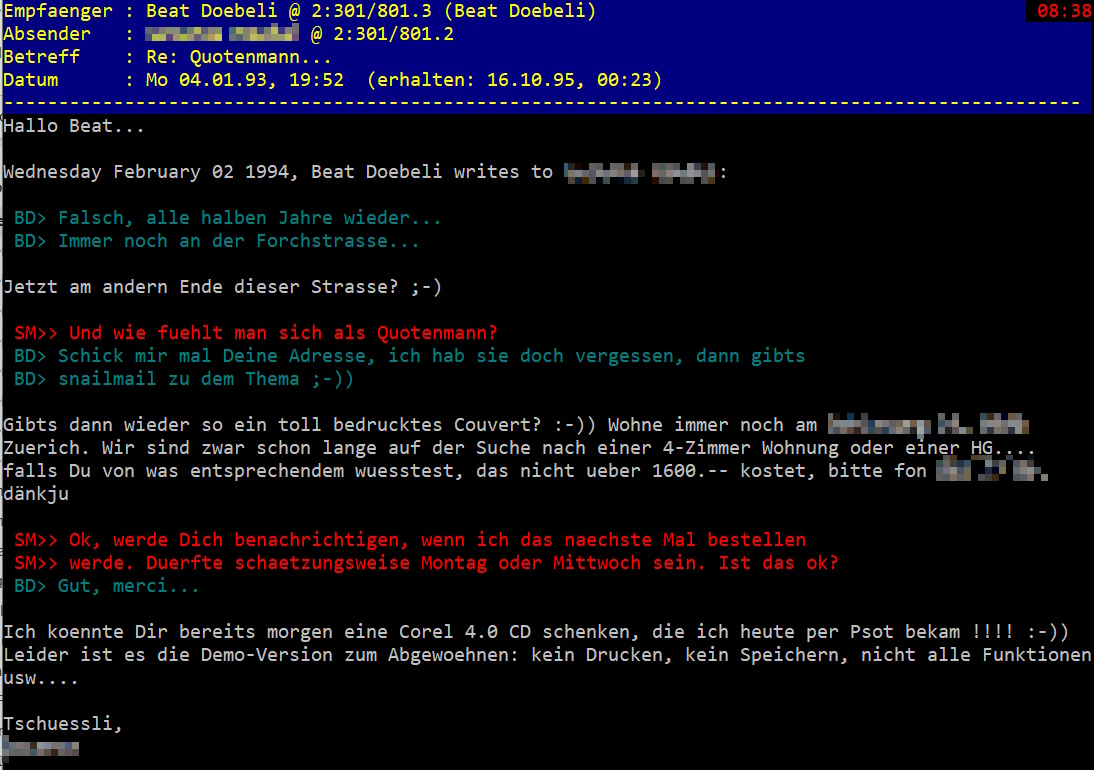

Wenn ich auf meinem Computer nach meinen ältesten Mails (Biblionetz:w00498) suche, muss ich ins letzte Jahrtausend zurückgehen. Auf die Schnelle habe ich ein Mail gefunden, von dem nicht sofort klar ist, ob es jetzt von 1993, 1994 oder 1995 stammt:

Was aber sofort klar wird: Es ist lange, sehr lange her. (Hinweis sowohl für jüngere als auch ältere Menschen: Das war für mich noch vor dem Internet. Es handelt sich um das Mailboxnetzwerk FidoNet). Und es zeigt auch, wie ich damals gelernt, habe Mails zu schreiben. Dieser Zitierstil sorgt heute in meinem Arbeitskontext öfters für Verwirrung. Eine Betrachtung zu digitaler Zusammenarbeit, die ich in Jöran Muuß-Merholz' beiden empfehlenswerten Büchern zu digitaler Zusammenarbeit (Biblionetz:b08860 und Biblionetz:b08924) erstaunlicherweise nicht gefunden habe.

Was aber sofort klar wird: Es ist lange, sehr lange her. (Hinweis sowohl für jüngere als auch ältere Menschen: Das war für mich noch vor dem Internet. Es handelt sich um das Mailboxnetzwerk FidoNet). Und es zeigt auch, wie ich damals gelernt, habe Mails zu schreiben. Dieser Zitierstil sorgt heute in meinem Arbeitskontext öfters für Verwirrung. Eine Betrachtung zu digitaler Zusammenarbeit, die ich in Jöran Muuß-Merholz' beiden empfehlenswerten Büchern zu digitaler Zusammenarbeit (Biblionetz:b08860 und Biblionetz:b08924) erstaunlicherweise nicht gefunden habe.

Was aber sofort klar wird: Es ist lange, sehr lange her. (Hinweis sowohl für jüngere als auch ältere Menschen: Das war für mich noch vor dem Internet. Es handelt sich um das Mailboxnetzwerk FidoNet). Und es zeigt auch, wie ich damals gelernt, habe Mails zu schreiben. Dieser Zitierstil sorgt heute in meinem Arbeitskontext öfters für Verwirrung. Eine Betrachtung zu digitaler Zusammenarbeit, die ich in Jöran Muuß-Merholz' beiden empfehlenswerten Büchern zu digitaler Zusammenarbeit (Biblionetz:b08860 und Biblionetz:b08924) erstaunlicherweise nicht gefunden habe.

Was aber sofort klar wird: Es ist lange, sehr lange her. (Hinweis sowohl für jüngere als auch ältere Menschen: Das war für mich noch vor dem Internet. Es handelt sich um das Mailboxnetzwerk FidoNet). Und es zeigt auch, wie ich damals gelernt, habe Mails zu schreiben. Dieser Zitierstil sorgt heute in meinem Arbeitskontext öfters für Verwirrung. Eine Betrachtung zu digitaler Zusammenarbeit, die ich in Jöran Muuß-Merholz' beiden empfehlenswerten Büchern zu digitaler Zusammenarbeit (Biblionetz:b08860 und Biblionetz:b08924) erstaunlicherweise nicht gefunden habe.

Ich kann programmieren!

Wir müssen lernen, dass Programmieren ungleich Programmieren ist

Bei der Diskussion anlässlich der Formulierung des Lehrplans 21 vor 10 bis 15 Jahren, ob Informatik obligatorisch in die Volksschule gehöre (Biblionetz:a00436) , erlebte ich Gegenwind auch von unerwarteter Seite: Informatikerinnen und Informatiker äusserten die Sorge, dass bald alle sagen würden "Ich kann programmieren!", weil sie in der Schule Informatikunterricht hatten. Das sei verheerend, denn dadurch würde die Bedeutung einer "echten" Informatikausbildung geschmälert.

Mit der aktuellen Entwicklung, dass generative Machine-Learning-Systeme immer besser Software schreiben können, nimmt derzeit die Zahl der Menschen zu, die auf LinkedIn laut ausrufen: "Ich kann programmieren!".

Ein Versuch der Klärung zur Beruhigung der Gemüter auf beiden Seiten.

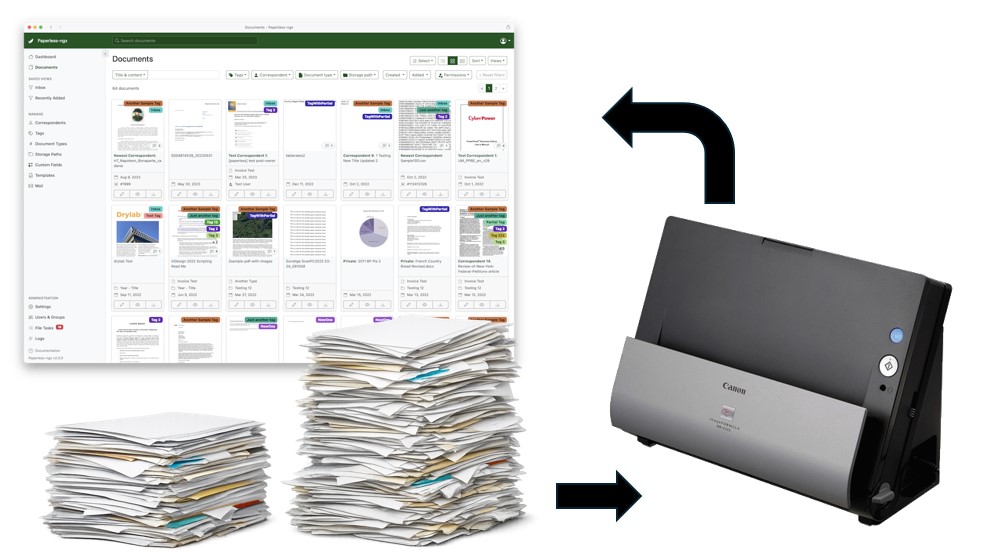

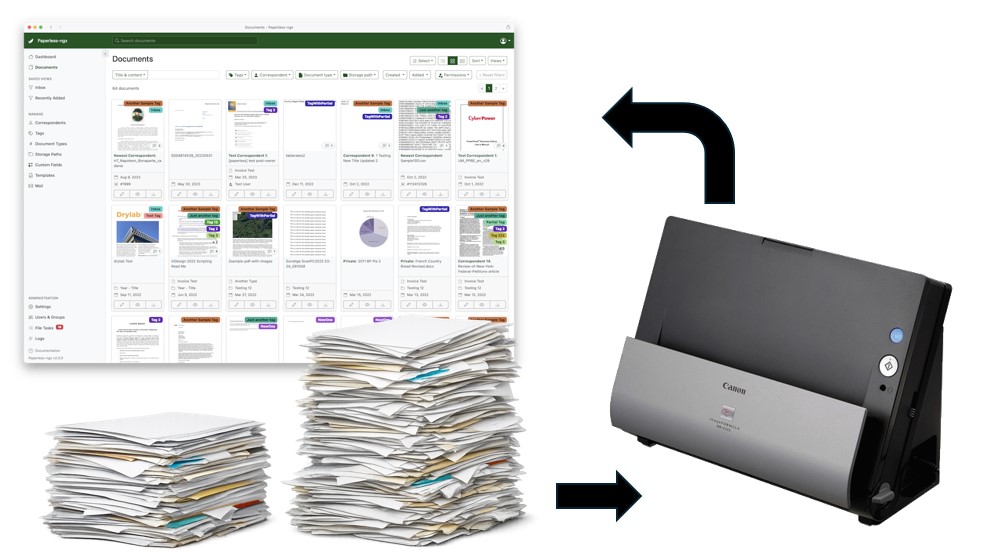

Das papierlose Familienbüro

wie ich mit einem Raspi und einem Einzugsscanner Spass an der Dokumentenablage bekommen habe

Kontoauszüge, Versicherungskorrespondenz, Handwerkerrechnungen und der gleichen mehr stapelt sich im Laufe der Zeit und es macht wenig Spass, diese Dokumente so abzulegen, dass man sie gegebenenfalls auch wiederfindet. Der Open-Source-Software paperless-ngx, meinem Raspberry Pi und einem Einzugsscanner sei Dank, habe ich aktuell sogar grad Spass am Ablegen von Dokumenten

Kontakt

- Beat Döbeli Honegger

- Plattenstrasse 80

- CH-8032 Zürich

- E-mail: beat@doebe.li

About me

Social Media

This page was cached on 20 Feb 2026 - 19:24.