Biblionetz

Postings zum Biblionetz

Biblionetz Archive

- 1Dec 2025

- 1Jul 2024

- 1Feb 2023

- 1Oct 2019

- 1Apr 2019

- 1Mar 2019

- 1Sep 2017

- 1Jan 2016

- 1Nov 2014

- 1May 2014

- 1Apr 2014

- 1Apr 2013

- 1Mar 2013

- 1Feb 2013

- 1Jan 2013

- 1Dec 2012

- 1Oct 2012

- 1Jul 2012

- 1Apr 2012

- 1Jun 2011

- 2May 2011

- 2Apr 2011

- 2Nov 2010

- 2Sep 2010

- 2Jul 2010

- 1Mar 2010

- 1Feb 2010

- 3Jan 2010

- 2Nov 2009

- 1Aug 2009

- 1Jul 2009

- 2May 2009

- 2Apr 2009

- 1Mar 2009

- 2Feb 2009

- 1Jan 2009

- 2Dec 2008

- 1Oct 2008

- 1Sep 2008

- 6Aug 2008

- 1Jun 2008

- 2Apr 2008

- 1Feb 2008

- 1Jan 2008

- 3Dec 2007

- 1Nov 2007

- 1Oct 2007

- 1Aug 2007

- 2Jul 2007

- 2May 2007

- 3Apr 2007

- 1Mar 2007

- 4Jan 2007

- 5Dec 2006

- 3Oct 2006

- 2Sep 2006

- 2Aug 2006

- 3Jul 2006

- 2Jun 2006

- 4May 2006

- 3Apr 2006

- 1Feb 2006

- 5Jan 2006

- 3Nov 2005

- 1Oct 2005

- 5Aug 2005

- 1Jul 2005

- 1Jul 2004

Biblionetz, Dec 2007

Postings zum Biblionetz

Nachdem ich dieses Jahr verschiedentlich aus dem Alltag als Biblionetzkar berichtet habe, hier ein Einblick ins Biblionetzkarleben während der Weihnachtsfeiertage.

Diese Schilderung ist vor allem für Nichtinformatiker/innen gedacht, da ich in letzter Zeit öfters die Meinung gehört habe, dass im Biblionetz wohl alles automatisch geschähe, ansonsten ein solcher Umfang nicht durch eine Einzelperson leistbar sei. Wie sich Nichtinformatiker/innen das Leben der Informatiker vorstellen...

(Ich bin mir aber bewusst, dass Nichtinformatiker/innen wohl spätestens beim zweiten Abschnitt gelangweilt weiterklicken und echte Informatiker/innen sich über meine stümperhaften Basteleien belustigen werden.)

Seit unterdessen elf Jahren (ja, das Biblionetz feiert dieser Tage den 11. Geburtstag...) ist die Zeit zwischen Weihnachten und Neujahr die Wiege neuer Biblionetzfunktionen. Es ist die Zeit, wo man sich grundsätzliche Gedanken machen, weltfremde Probleme vieldimensional im Kopf wälzen und danach auch noch mehrere Tage und Nächte hintereinander programmieren kann. Naja, zumindest vor 11 Jahren konnte man das, heute siehts auch anders aus und entsprechend wenig wird sich im Biblionetz ändern.

Für diese Festtage habe ich mir eigentlich etwas einfaches vorgenommen: Ich wollte wieder einmal Daten aus der Computer Science Library importieren.

Herumspielen Einarbeiten in xmlstarlet auf dem Programm.

Ok, auch das ist erledigt, ich scheine die Syntax begriffen zu haben. Na dann, geben wir doch dem Programm die 420 MByte grosse XML-Datei zum Futtern. Wird wohl ein wenig dauern, also einen Kaffee aufgesetzt und etwas Schokolade genascht...

Mehrere praktische Computerstillstände und viele Pralinen später die Erkenntnis: XML-Tools, welche die zum Frass vorgeworfenen XML-Daten als Baum im Hauptspeicher aufbauen, brauchen viel Speicher. Bei 420 MByte sehr, sehr viel Speicher. Keine gangbare Lösung, das Problem lässt sich weder durch mehr Pralinen noch durch mehr Speicher wirklich lösen.

Eine weitere Recherche später weiss ich, dass es neben DOM-orientieren XML-APIs auch ereignisorientierte XML-APIs gibt, u.a. Simple API for XML (SAX) (siehe Wikipedia), die eben nicht die ganze XML-Struktur speicherfressend im Speicher aufzubauen versuchen. Und erstaunlicherweise unterstützt selbst MS Access 2003 bzw. die entsprechende XML-Bibliothek SAX. Die Einarbeitung in diese MS-Spezifika ist mir dann aber zu mühsam, und so entsteht eine Bastellösung, über deren Details ich mich hier lieber ausschweige.

Danach kommen eigentlich nur noch die üblichen Probleme von Bibliothekaren: Dubletten im Biblionetz, unterschiedliche Schreibweisen von Personennamen und Sonderzeichen in allen möglichen Zeichensätzen. Also hier und dort einen Konverter oder Filter geschrieben, der in 80% der Fälle funktioniert und in 20% der Fälle …

Beim Recherchieren bin ich über http://www.io-port.net/ gestolpert:

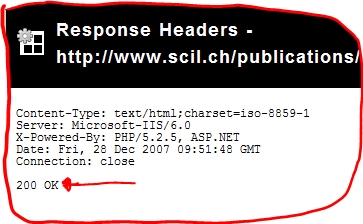

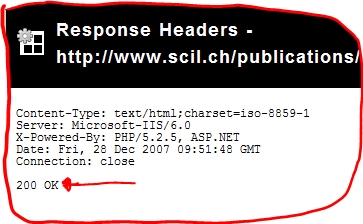

Der Webserver liefert aber den (für Maschinen gedachten) Status 200 OK zurück, so dass Linkchecker nichts davon mitbekommen, dass die Seite gar nicht mehr existiert. auauaua!

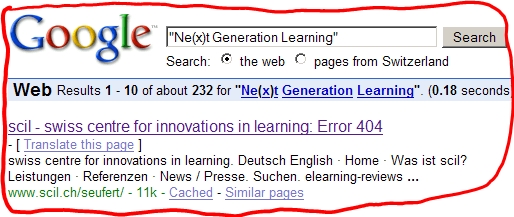

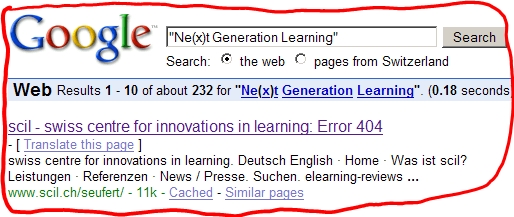

Tja, das führt dann halt dazu, dass Google als ersten Treffer eine Fehlermeldung bringt:

Soviel von der Biblionetz-Entwicklungsfront. Mehr liegt leider dieses Jahr nicht drin. All die anderen lustigen Ideen müssen warten. Mindestens bis nächste Weihnachten.

The DBLP server provides bibliographic information on major computer science journals and proceedings. Initially the server was focused on DataBase systems and Logic Programming (DBLP), now it is gradually being expanded toward other fields of computer science. You may now read "DBLP" as "Digital Bibliography & Library Project".

The server indexes more than 955000 articles and contains several thousand links to home pages of computer scientists (November 2007).

Diese bibliographischen Daten lassen sich u.a. als 420 MByte grosse XML-Datei herunterladen, ein gefundenes Fressen also, um sich mit der Datenextraktion aus XML-Strukturen zu beschäftigen (das ist Weiterbildung und Rätselspass in einem). Als erstes ist also eine Einarbeitung in XPath (siehe Wikipedia), einer Abfragesprache für XML-Daten, notwendig.

Gut, theoretisch ist das Konzept verstanden, nun zur Praxis. Eine kurze Recherche führt mich zum auch für Windows verfügbaren Kommandozeilenwerkzeug xmlstarlet (siehe Wikipedia), einer am MIT entwickelten Open Source Software. Somit steht das

Das Informatikportal von FIZ Karlsruhe ermöglicht die einfache und schnelle Recherche in mehr als zwei Millionen Publikationen der Informatik und verwandter Themen. Der Datenbestand ist der umfangreichste seiner Art.

Unter anderem bietet io-port auch die Volltexte aller Lecture Notes in Informatics (LNI). Für mich interessant: Alle INFOS und DelFI-Konferenzbände im Volltext. Leider sind diese Volltexte aber nur für zahlende Universitäten und GI-Mitglieder abrufbar. Tja, und keine der Universitäten, bei denen ich eine virtuelle Identität besitze, scheint bisher eine io-port-Lizenz zu besitzen. Und da ich nicht in Deutschland, sondern in der Schweiz wohne, bin ich nicht GI- sondern SI-Mitglied, und ob ich damit Zugang kriege, muss ich noch abklären. grummel, die Volltexte sind vorhanden, aber nicht frei verfügbar...

Aus Frust bastel ich mir ein Google-Interface, das mit Hilfe von automatisierten Abfragen bei Google versucht, Volltexte von im Biblionetz eingetragenen wissenschaftlichen Texten zu finden. Auch dies eine 80-20-Lösung: Zwar finde ich damit einige Texte, aber der Code funktioniert nicht vollautomatisch, sondern benötigt meine Hilfe, um den Spreu vom Weizen zu trennen.

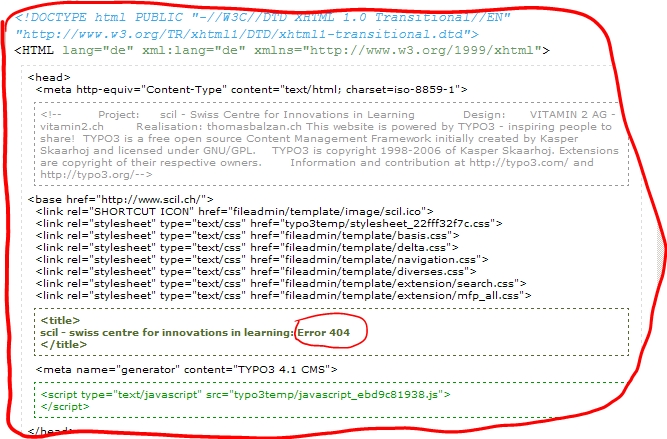

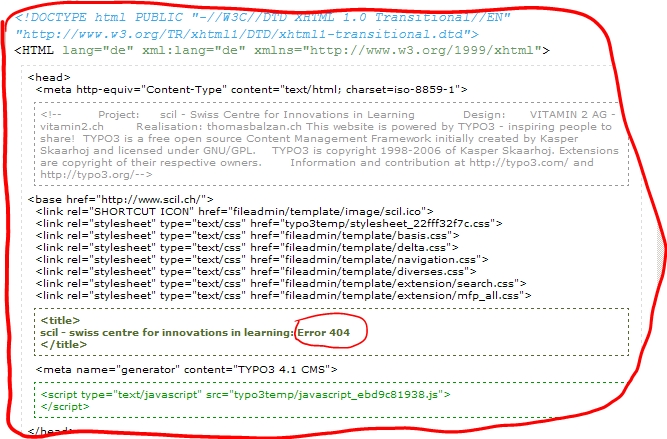

Daneben auch normaler Biblionetzkar-Alltag: Organisationen, die ihren Webauftritt überarbeitet haben - gähn - und dabei - seufz - alle alten Adressen haben sterben lassen. Prominentes Beispiel diesmal: scil, swiss centre for innovations in learning: Versucht man einen SCIL-Bericht unter der bisherigen Adresse abzurufen, meint die Website nur: Sorry. This site does not exist in english.

Das Nichtinformatiker/innen nicht an stabile URLs denken, ist ja noch halbwegs nachvollziehbar. Dass aber Entwickler von Content Management Systemen nicht mal mehr die Grundideen von HTTP berücksichtigen, ist mir weiterhin unverständlich und bringt mich jedes Mal in Rage.

Die Fehlerseite bei SCIL trägt zwar neckisch den Code 404 im (für Menschen gedachten) Titel der Seite:

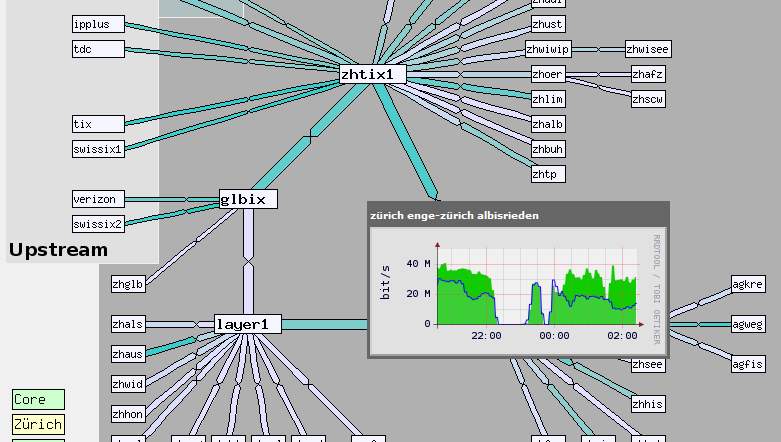

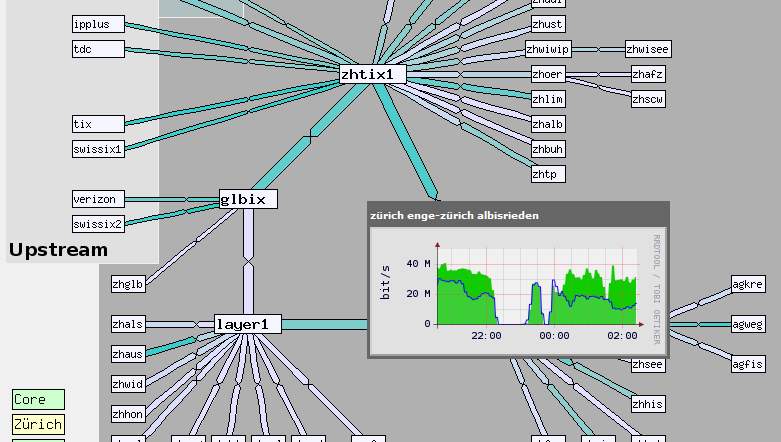

Gestern Mittwoch, den 12. Dezember 2007 war dieser Server zeitweise nicht mehr erreichbar. Auf meiner Seite betraf dies das Biblionetz, das Weblog hier, das gesamte Wiki (inkl. der Gymnasial-Wikis), aber auch meine private Mail.

Ich möchte betonen, dass es nicht an unserem Server lag, der friedlich (und etwas gelangweilt) vor sich hin schnurrte, sondern am Netzwerk dazwischen, wie auf diesem Netzwerkdiagramm zu sehen ist (der Unterbruch in der grünen Kurve):

klicken zum Vergrössern

Für den User kommts aufs selbe raus, für uns ist die Fehlerbehebung schwieriger: Wir sind zwar nicht schuld, können aber dafür auch wenig dagegen tun.

,

klicken zum Vergrössern

%STARTBLOG%Nachdem der Artikel zum Biblionetz vor anderthalb Jahren bereits nach etwa einer Woche aus der deutschsprachigen Wikipedia raus geflogen ist (siehe BeatsBiblionetzInDeutscherWikipedia), droht nun den Wikipedia-Verweisen auf das Biblionetz seit September 2007 das gleiche Schicksal:

Hmm, seither sind aus den ca. 60 Verweisen 53 geworden. So resolut ist man also bei der Säuberungsaktion bisher doch nicht vorgegangen. Uff...

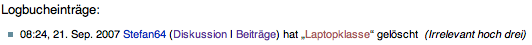

In der Wikipedia wird ja so einiges gelöscht, der Begriff "Laptopklasse" ist beispielsweise "irrelevant hoch drei":

Vielleicht bekommen wir gemeinsam einen guten Artikel hin, der bleiben kann. - Wer macht mit?

Vielleicht bekommen wir gemeinsam einen guten Artikel hin, der bleiben kann. - Wer macht mit?

-- Main.TorstenOtto - 11 Dec 2007

- übrigens werde ich in zukunft wegen (meist) mieser inhaltlicher qualität links auf beats netz aus artikeln nehmen. hoffe es gibt keine einwände weil die grafen ja so schick sind o.ä.? Ca$e 09:28, 19. Sep. 2007 (CEST)

- Viel Spaß, es warten noch locker über 50 weitere Verlinkungen. --Asthma 10:52, 19. Sep. 2007 (CEST)

- Naja, so viel sind 60 Verlinkungen ja nun auch nicht (ein paar hundert zweifelhafte Meyers-Artikelkopien sind dagegen ein ganz anderes Problem). Aber inzwischen dürfte wohl Übereinstimmung darüber herrschen, dass 99% der Seiten dort bei weitem nicht unseren Qualitätsansprüchen genügen. Daher sollte m.E. jeder, der über einen solchen Link stolpert, diesen nach kurzer Überprüfung löschen. Danke für den Hinweis, Ca$e. --Markus Mueller 11:19, 19. Sep. 2007 (CEST)

- Viel Spaß, es warten noch locker über 50 weitere Verlinkungen. --Asthma 10:52, 19. Sep. 2007 (CEST)

In der Wikipedia wird ja so einiges gelöscht, der Begriff "Laptopklasse" ist beispielsweise "irrelevant hoch drei":

-- Main.TorstenOtto - 11 Dec 2007

Kontakt

- Beat Döbeli Honegger

- Plattenstrasse 80

- CH-8032 Zürich

- E-mail: beat@doebe.li

About me

Social Media

This page was cached on 31 Jan 2026 - 12:20.