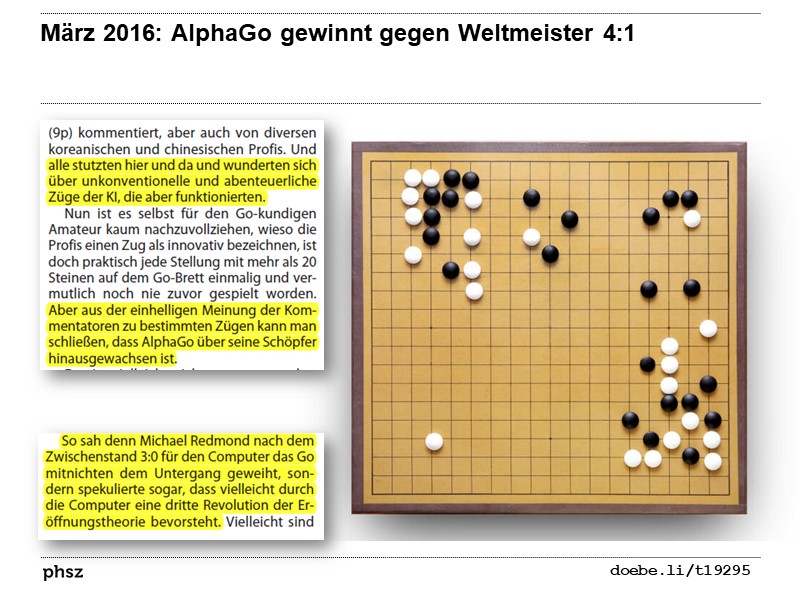

Und alle stutzten hier und da und wunderten sich über unkonventionelle und abenteuerliche Züge der KI, die aber funktionierten.

Nun ist es selbst für den Go-kundigen Amateur kaum nachzuvollziehen, wieso die Profis einen Zug als innovativ bezeichnen, ist doch praktisch jede Stellung mit mehr als 20 Steinen auf dem Go-Brett einmalig und vermutlich noch nie zuvor gespielt worden. Aber aus der einhelligen Meinung der Kommentatoren zu bestimmten Zügen kann man schließen, dass AlphaGo über seine Schöpfer hinausgewachsen ist.

Das ist vielleicht nicht ganz verwunderlich. Die neuronalen Netze, die zentraler Bestandteil von AlphaGo sind, wurden nämlich nur zu Beginn mit Millionen von Stellungen aus Partien starker menschlicher Spieler trainiert. Hier lernten sie zunächst, Menschen in ihrem Spiel zu imitieren. Dann kam aber eine Phase des Reinforcement Learning: Das neuronale Netz spielte Millionen von Partien gegen sich selbst und lernte daraus, wie man dieses Spiel noch besser spielt. Während ein werdender Profi in Asien sein halbes Leben damit verbringt, das Jahrhunderte alte Wissen und die Traditionen zu verinnerlichen, durfte AlphaGo ganz alleine lernen, ohne die Vorurteile eines Lehrers.

So sah denn Michael Redmond nach dem Zwischenstand 3:0 für den Computer das Go mitnichten dem Untergang geweiht, sondern spekulierte sogar, dass vielleicht durch die Computer eine dritte Revolution der Eröffnungstheorie bevorsteht.

Quelle: Haradl Bögeholz Jubel und Ernüchterung c't 7/2016, S. 44 (Biblionetz:t19295).

Nun ist es selbst für den Go-kundigen Amateur kaum nachzuvollziehen, wieso die Profis einen Zug als innovativ bezeichnen, ist doch praktisch jede Stellung mit mehr als 20 Steinen auf dem Go-Brett einmalig und vermutlich noch nie zuvor gespielt worden. Aber aus der einhelligen Meinung der Kommentatoren zu bestimmten Zügen kann man schließen, dass AlphaGo über seine Schöpfer hinausgewachsen ist.

Das ist vielleicht nicht ganz verwunderlich. Die neuronalen Netze, die zentraler Bestandteil von AlphaGo sind, wurden nämlich nur zu Beginn mit Millionen von Stellungen aus Partien starker menschlicher Spieler trainiert. Hier lernten sie zunächst, Menschen in ihrem Spiel zu imitieren. Dann kam aber eine Phase des Reinforcement Learning: Das neuronale Netz spielte Millionen von Partien gegen sich selbst und lernte daraus, wie man dieses Spiel noch besser spielt. Während ein werdender Profi in Asien sein halbes Leben damit verbringt, das Jahrhunderte alte Wissen und die Traditionen zu verinnerlichen, durfte AlphaGo ganz alleine lernen, ohne die Vorurteile eines Lehrers.

So sah denn Michael Redmond nach dem Zwischenstand 3:0 für den Computer das Go mitnichten dem Untergang geweiht, sondern spekulierte sogar, dass vielleicht durch die Computer eine dritte Revolution der Eröffnungstheorie bevorsteht.

- Biblionetz:b00029 Douglas Hofstadter: Gödel, Escher, Bach (1979)

- Biblionetz:b00012 Douglas Hofstadter & Daniel C. Dennett: * Einsicht ins Ich* (1981)

- Biblionetz:b00027 John R. Searle: Geist, Hirn und Wissenschaft (1984)

- Biblionetz:b01496 Marvin Minksy: The Society of Mind (1985)

- Biblionetz:b00193 Hubert L. Dreyfus & S. Dreyfus: Mind over Machine (1986)

- Biblionetz:b00015 Roger Penrose: Computerdenken (1989)

- Biblionetz:b00061 Francisco Varela, Evan Thomson & Eleanor Rosch: Der mittlere WEg der Erkenntnis (1991)